Обзор существующих моделей нейронов

Скачать:

![]() Doc (880 kB 2014-06-27 18:18:42)

Doc (880 kB 2014-06-27 18:18:42)

![]() Pdf (1 MB 2014-06-27 18:14:57)

Pdf (1 MB 2014-06-27 18:14:57)

Одним из важных направлений разработки интеллектуальных системявляется теория нейронных сетей. На сегодняшний день искусственные нейронные сети (ИНС) применяют для:

- классификации объектов;

- кластеризации/категоризации (классификации образов «без учителя»);

- аппроксимации функций;

- предсказаний/прогнозов;

- решения задач оптимизации;

- создания систем памяти, адресуемой по содержанию (ассоциативной памяти);

- решениязадач управления в слабодетерминированой среде.

Искусственный нейрон имитирует в первом приближении свойства биологического нейрона. На вход искусственного нейрона поступает некоторое множество сигналов, каждый из которых является выходом другого нейрона.

Для того чтобы верно оценить какие существуют искусственные нейроны, что они позволяют реализовывать, как можно улучшить существующие модели нейронов и нейронных сетей и какими могут быть новые разработки в этой области, необходимо произвести их обзор и классификацию.

1 Классификация моделей нейронов

Возможно множество способов классификации моделей нейронов. Для лучшего понимания существующих достижений в сфере моделирования нейронов и нейронных сетей рассмотрим некоторые из возможных классификаций.

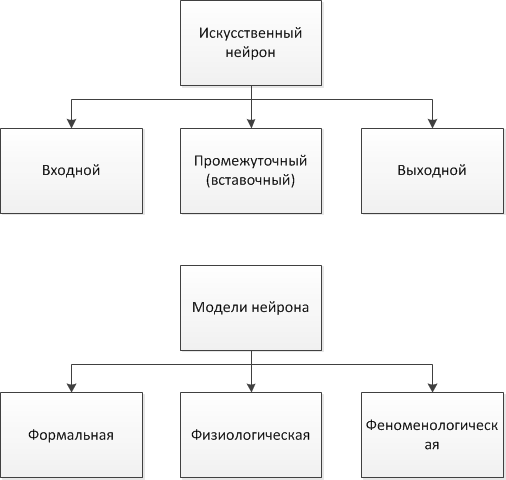

Во-первых, нейроны можно классифицировать на основе положения нейронов в топологии сети:

1) входные нейроны: принимают исходный вектор, кодирующий входной сигнал. Как правило, не выполняют вычислительных операций, а просто передают полученный входной сигнал на выход, возможно, усилив или ослабив его;

2) выходные нейроны: представляют выходы сети. В выходных нейронах могут производиться какие-либо вычислительные операции;

3) промежуточные нейроны — выполняют основные вычислительные операции.

Во-вторых, классификацию нейронов можно производить по степени разработки математического описания модели нейрона и качественного описания поведения нейрона (Рис.1):

Рис.1. Классификация нейронов по топологии и описанию

1) формальные (абстрактные) нейроны: отличаются хорошо разработанным математическим описанием, ноигнорируют многие свойства своего биологического двойника. Однако вопрос того, какие не описываемые формальными нейронами свойства биологических прототипов могут позволить существенно расширить сферу применения ИНС, или сложность решаемых ими задач, в общем случае остается открытым;

2) физиологические нейроны: отличаются количественным описанием поведения нейронов, порождены из экспериментов над биологическими нейронами;

3) феноменологические модели нейронов: не имеют строгой математической и опытной базы.

Формальные нейроны в свою очередь тоже могут быть разделены по нескольким признакам:

1.1) по виду функции активации;

1.2) по изменяемости весов входов:

- неизменные веса (например, нейрон Макклока-Питтса);

- управляемые веса;

- веса, перестраивающиеся в зависимости от входного по данному каналу сигнала (например, «Instar» Гроссберга.);

- веса типа синапсов Хебба, изменяющиеся под влиянием выходного сигнала нейрона.

- детерминированные модели;

- стохастические модели.

1.3) в зависимости от вероятности значения выходного сигнала:

В-третьих, нейроны можно подразделять в зависимости от их аппаратной реализации:

1) цифровые модели – нейроны выполняются на микросхемах средней и высокой степени интеграции; на кристалле реализуется непосредственно нейронная сеть, т. е. отдельные нейроны не выделяются как самостоятельные единицы, т.к. модель разрабатывают для решения конкретных задач;

2) аналоговые модели: позволяют воспроизводить пространственное и временное суммированием возбуждающих сигналов, свойства абсолютной и относительной рефрактерности, процессы переработки информации в отдельном нейроне и при взаимодействии нейронов. Нейрон рассматривается как устройство, состояние которого может непрерывно меняться от полного покоя до некоторого максимального уровня возбуждения.

1.1. Формальные нейроны

Первая модель формального нейрона была разработана Маккалоком и Питтсом (Рис.2). Формальный нейрон представляет собой математическую модель простого процессора, имеющего несколько входов и один выход. Вектор входных сигналов, поступающих через дендриты, преобразуется нейроном в выходной сигнал, распространяющийся по аксону, с использованием трех функциональных блоков: локальной памяти, блока суммирования и блока нелинейного преобразования.

Вектор локальной памяти содержит информацию о весовых множителях, с которыми входные сигналы будут интерпретироваться нейроном. Эти переменные веса являются аналогом чувствительности пластических синаптических контактов. Выбором весов достигается та или иная интегральная функция нейрона.

В блоке суммирования происходит накопление общего входного сигнала (обычно обозначаемого символом net), равного взвешенной сумме входов.

В модели Маккалока-Питтса отсутствуют временные задержки входных сигналов, поэтому значение net определяет полное внешнее возбуждение, воспринятое нейроном. Отклик нейрон далее описывается по принципу "все или ничего", т. е. переменная подвергается нелинейному пороговому преобразованию, при котором выход (состояние активации нейрона) Y устанавливается равным единице, если net>, и Y=0 в обратном случае. Значение порога (часто полагаемое равным нулю) также хранится в локальной памяти. Таким образом, в модели Маккалока-Питтса используется пороговая активационная функция (по аналогии с электронными системами активационную функцию можно считать нелинейной усилительной характеристикой искусственного нейрона).

Используется при моделировании простых сетей, например, персептронов.

Помимо пороговой бинарной функции (функции Хевисайда), в качестве функции активации могут быть использованы:

1. Пороговая биполярная функция активации (сигнатурная).

2. Линейная функция, а также ее вариант - линейная функция с погашением отрицательных сигналов.

Используется в нейронах, образующих линейные нейронные сети, а также в выходных слоях сетей на радиальных базисных функциях.

3. Сигмоидальная (S-образная) функция:

а) логистическая

С. Гроссберг [9] обнаружил, что сигмоидальная функция обладает избирательной чувствительностью к сигналам разной интенсивности, что соответствует биологическим данным, и решает поставленную им дилемму шумового насыщения (т.е. обрабатывает как слабые, так и сильные сигналы). Наибольшая чувствительность наблюдается вблизи порога, где малые изменения сигнала net приводят к ощутимым изменениям выхода. Напротив, к вариациям сигнала в областях значительно выше или ниже порогового уровня сигмоидальная функция не чувствительна, так как ее производная при больших и малых аргументах стремится к нулю. Коэффициент усиления вычисляется как отношение приращения величины Y к вызвавшему его небольшому приращению величины net. Он выражается наклоном кривой при определенном уровне возбуждения и изменяется от малых значений при больших отрицательных возбуждениях (кривая почти горизонтальна) до максимального значения при нулевом возбуждении и снова уменьшается, когда возбуждение становится большим положительным.

То, что производная логистической функции может быть выражена через её значение облегчает использование этой функции при обучении нейронной сети по алгоритму обратного распространения. Логистическая функция в нейронных сетях используется наиболее часто.

б) гиперболический тангенс

Гиперболический тангенс симметричен относительно начала координат, и в точке net = 0 значение выходного сигнала Yравно нулю. В отличие от логистической функции, гиперболический тангенс принимает значения различных знаков, и это его свойство применяется для целого ряда сетей. Идеально подходит для пользовательской настройки многослойных персептронов.

4. Радиально-базисная функция передачи – функция, которая принимает в качестве аргумента расстояние между входным вектором и некоторым наперед заданным центром активационной функции. Значение этой функции тем выше, чем ближе входной вектор к центру. В качестве радиально-базисной чаще всего используют функцию Гаусса.

где S = ||X - C|| - расстояние между центром Cи вектором входных сигналовX. Скалярный параметр определяет скорость спадания функции при удалении вектора от центра и называется шириной окна, параметр R определяет сдвиг активационной функции по оси абсцисс. В качестве расстояния между векторами могут быть использованы различные метрики, чаще всего используется евклидово расстояние.

Сети с такими нейронами называются вероятностными и регрессионными. В реальных сетях активационная функция этих нейронов может отражать распределение вероятности какой-либо случайной величины, либо обозначать какие-либо эвристические зависимости между величинами.

Нейроны, использующие радиально-базисные функции, называются радиально симметричными, а соответствующие им сети - RBF-сетями или сетями радиальных базисных функций. В основе RBF-сетей лежит подход, основанный на разбиении пространства окружностями или (в общем случае) гиперсферами. RBF-сети применяются для решения задач классификации, они являются наиболее эффективными, когда доступно большое количество обучающих векторов.

5. Экспоненциальная функция.

Она используется, например, в первом скрытом слое нейронов вероятностных нейронных сетей. Достоинство таких сетей состоит в том, что их архитектура позволяет не только осуществить классификацию объектов, но и определить вероятность справедливости принимаемых решений.

Иногда используют экспоненциальные функции, выходы которых нормируются так, чтобы сумма всех активаций слоя равнялась 1. Их применяют в выходных слоях многослойных персептронов, специально сконструированных для задач классификации таким образом, чтобы выходы можно было интерпретировать как вероятности принадлежности к классу.

6. Квадратный корень [8].

Преобразует активации сети Кохонена, т.е. квадраты расстояний, в выходные значения, представляющие сами расстояния. Сеть Кохонена рассчитана на обучение без учителя и применяется для разведывательного анализа данных (распознавания кластеров в данных, устанавливания близости классов, решения задач классификации, обнаружения новых явлений).

7. Тригонометрический синус.

Используется при распознавании радиально распределенных данных.

8. Пилообразная функция [8].

Представляет кусочно-линейный вариант сигмоидальной функции. Обладает невысоким качеством обучения, но быстро работает.

При развитии модели Маккалока-Питтса были получены следующие модели нейронов (Рис.5):

Рис.5. Формальные нейроны

1.1.1 Адаптивный линейный нейрон (нейрон типа "адалайн")

Это нейрон со структурой формального нейрона Маккалока-Питтса и сигнатурной функцией активации [1]. В данном нейроне в процессе минимизации квадратичной ошибки осуществляется адаптивный подбор весовых коэффициентов.

Для нахождения значений весовых коэффициентов в следующий момент применяют алгоритм градиентного обучения.

1.1.2 Нейрон Паде

Нейрон Паде может использоваться как обобщение нейрона типа "адалайн" в тех случаях, когда линейных функций становится недостаточно, в частности, в задачах интерполяции эмпирических зависимостей.

На практике такая модель практически не используется, т.к. она усложняет процесс построения нейросетевой модели, не внося значительных дополнительных возможностей [10].

1.1.3 Нейрон с квадратичным сумматором

Квадратичный сумматор может вычислять произвольный полином второго порядка от вектора входных сигналов.

Для многомерных нормальных распределений нейрон с квадратичным сумматором является наилучшим классификатором.

Коэффициенты сумматора , и rуточняются, исходя из определения квадратичной ошибки. Недостаток такого классификатора – большое число настраиваемых параметров.

1.1.4 Сигма-Пи нейроны

Являются обобщением нейронов с линейной и квадратичной функциями активации на случай представления функции активации netполиномом степени N (N – число входов нейрона).

1.1.5. «Instar» и «Outstar» Гроссберга [1]

Структуры «Instar» и «Outstar» представляют собой взаимодополняющие элементы: «Instar» адаптирует веса связей нейрона к входным сигналам, а «Outstar» - к выходным. Функции активации чаще всего являются линейными.

Могут обучаться как с учителем, так и без учителя. Применяется при решении задач классификации.

1.1.6. Модель нейрона Хебба

Структурная схема нейрона Хебба соответствует стандартной структуре формального нейрона. Д. Хебб заметил, что связь между двумя клетками усиливается, если обе клетки активируются одновременно, и предложил формальное правило обучения, в соответствии с которым вес wi нейрона изменяется пропорционально произведению его входного и выходного сигналов. Правило Хебба может применяться для нейронных сетей различных типов с любыми функциями активации отдельных нейронов.

При обучении с учителем вместо выходного сигнала yиспользуется ожидаемая от этого нейрона реакция d.

В результате применения правила Хебба веса нейрона могут принимать произвольно большие значения. Один из способов стабилизации процесса обучения по правилу Хебба состоит в учете последнего значения wi, уменьшенного на коэффициент забывания.

Значение выбирается из интервала (0,1) и чаще всего составляет некоторый процент от коэффициента обучения . Рекомендуемые значения коэффициента забывания <0.1, при которых нейрон сохраняет большую часть информации, накопленной в процессе обучения, и получает возможность стабилизировать значения весов на определенном уровне.

1.1.7 Нейроны типа WTA (WinnerTakesAll – Победитель получает все)

Представляют группу конкурирующих между собой нейронов, получающих одни и те же входные сигналы xj. Сравнением выходных значений сумматоров определяется нейрон-победитель с максимальной величиной ui, на его выходе устанавливается сигнал yi = 1, остальные (проигравшие) нейроны переходят в состояние 0, что блокирует процесс уточнения их весовых коэффициентов. Веса же победившего нейрона уточняются по упрощенному правилу Гроссберга.

Следствием этой конкуренции становится самоорганизация процесса обучения.

В отличие от детерминированных моделей в стохастической модели выходное состояние нейрона зависит не только от взвешенной суммы входных сигналов, но и от некоторой случайной переменной, значения которой выбираются при каждой реализации из интервала (0,1).

Процесс обучения нейрона в стохастической модели состоит из следующих этапов:

1) расчет взвешенной суммы для каждого нейрона сети;

2) расчет вероятностей;

3) генерация значения случайной переменной и формирование выходного сигнала y, если R<P(y), или –yв противном случае;

4) адаптация весовых коэффициентов wij (при фиксированных yi) по используемым правилам.

1.2 Физиологические модели нейронов.

1.2.1 Модель порогового интегратора (one-compartmental linear leaky integrate-and-fire neuron)

Приближённо описывает изменение мембранного потенциала посредством суммирования входных сигналов, прежде всего синаптических токов, согласно закону Ома, и определяет момент генерации спайка (потенциала действия) как момент времени, когда мембранный потенциал превышает пороговое значение.

В ответ на стимуляцию ступенькой тока при удачном подборе параметров модель может отражать спайковую активность в смысле согласования стационарной частоты спайков с экспериментальной. Однако эта модель неспособна воспроизвести форму спайков, профиль изменения потенциала между спайками, адаптацию спайков в виде относительно медленного увеличения межспайковых интервалов; проявление спонтанной активности в виде нерегулярности спайков и флуктуаций потенциала.[4].

1.2.2. Модель Ходжкина-Хаксли (Hodgkin - Huxley Model)

Предложена для моделирования распространения возбуждения в гигантском аксоне кальмара. Ходжкин и Хаксли при проведении экспериментов обнаружили действие трех различных типов ионного тока на возбудимость мембраны, а именно, натриевого, калиевого и тока утечки, состоящего в основном из ионов хлора.

Обычно при раздражении клетки при помощи микроэлектрода можно считать, что полный ток через мембрану равен нулю.

При выводе законов изменения проводимостей мембраны для ионов натрия и калия, внимание в первую очередь обращалось на достижение точного совпадения расчетных и экспериментальных данных.

Модель Ходжкина-Хаксли уделяет основное внимание мембране нейрона, не рассматривает детально синаптический аппарат, оперируя лишь следствиями его воздействия на мембрану нейрона. Более современные модели отличаются от модели Ходжкина-Хаксли в основном учетом большего количества типов ионов.

1.2.3 Модель коркового нейрона с шумом [3]

Поведение модели Ходжкина-Хаксли по сравнению с поведением естественного нейрона излишне регулярно, не обладает адаптацией и спонтанной активностью. В большой мере эти недостатки устраняются для модели коркового пирамидного нейрона, рассматривающего более полный набор типов ионных каналов.

Для имитации спонтанной активности вводится модель цветного шума (Ornstein-Uhlenbeckprocess) для синаптического тока IS.

Такая модель пирамидного нейрона демонстрирует поведение, весьма похожее на поведение нейрона зрительной коры крысы.

1.2.4. Модель Конора-Валтера-МакКоуна (Connor, Walter, McKown)

По сравнению с моделью Ходжкина-Хаксли включает в себя дополнительно ток IA = -gA(v-vA)A3B. По сравнению с моделью Ходжкина-Хаксли имеет более широкий диапазон частот вспышек активности.

1.2.5. Модель Мориса-Лекара (ML - Morris-Lecar model)

Упрощенная модель Ходжкина-Хаксли. Описывает такие свойства живого нейрона как генерация спайков и режим невосприимчивости к внешнему воздействию. Данная модель описывает влияние на возбудимость мембраны колебаний калиевой и кальциевой проводимостей.

Недостатком является то, что в рамках динамической модели с двухмерным фазовым пространством невозможно описать все детали динамики нейрона (например, хаотические колебании мембраны клетки) [11].

1.2.6. Модель ФитцХью - Нагумо (FHN-model) [2]

Представляет собой упрощенную модель, воспроизводящую основные свойства волн возбуждения в модели Ходжкина-Хаксли. Модель ФитцХью-Нагумо содержит две переменные: быструю переменную u, соответствующую мембранному потенциалу в полной модели, и медленную переменную v.

C , ε , β и γ - параметры модели, причем параметр ε предполагается малым: ε << 1. У модели наблюдается область параметров, для которых существуют спиральные волны и область параметров, для которых наблюдается меандр спиральных волн. Эта модель хорошо аналитически исследована и часто используется в качестве локального элемента при описании распространения волн в активных биологических средах, таких как сердечная мышца или мозговая ткань.

1.2.7. Модель Бонхоффера – Ван дер Поля (Bonhoeffer-Van der Pol oscillator)

Первоначально была предложена для моделирования нервных импульсов[6]. Позднее уравнения Бонхоффера – Ван дер Поля, включающие пространственную диффузию, стали известны как уравнения ФитцХью-Нагумо.

1.2.8. Модели Мак-Алистера-Нобла-Цяня и Билера-Рейтера

Являются модификациями модели ФитцХью–Нагумо, самыми точными из всех, основанных на измерении тока, созданными для понимания распространения волны возбуждения в сердце: для волокон Пуркинье и для миокарда соответственно. Эти модели имеют некоторые недостатки из-за их использование только для отдельных участков проводящей системы сердца, а также наличие большого количества переменных в уравнениях моделей.

1.2.9 Модель Алиева-Панфилова [2]

Модифицированная версия модели ФитцХью-Нагумо, имеющая ряд существенных отличий, которые приближают ее свойства к свойствам сердечной ткани. С использованием этой модели в 2006 году удалось обнаружить новое автоволновое явление — серпантин (его следует рассматривать, как состояние сердечной ткани). Модель также содержит две переменных u и v.

Параметры модели: ε0<< 1, k, α, µ1, µ2.

1.2.10. Модель Зимана [2]

Модель предложена для учета различной крутизны переднего и заднего фронтов импульса возбуждения при пульсации сердца и нервных импульсах. Модель описывается тремя переменными, что является необходимым для различной крутизны фронтов. В программной реализации используется модифицированная модель Зимана, дополненная двумя параметрами p и q, которые в оригинале были равны нулю.

1.2.11. Модифицированная модель Бикташева

Исходная модель была предложена для моделирования явления диссипации фронта и представляет собой упрощенную модель Ходжкина-Хаксли. Однако в таком виде модель описывала бистабильную среду и моделировала передний фронт волны возбуждения, а фактически - волну переключения.

1.2.12. Трехмерная модель Хиндмарш-Розе

Модель динамики мембранного потенциала нейрона. Она является, по сути, законом Кирхгофа, записанным для потенциала клеточной мембраны как для суммы ионных токов текущих через нее.

1.2.13. Двумерная модель Хиндмарш-Розе

Модель является двумерным упрощением 4-х мерной модели Ходжкина-Хаксли, описывающей главные свойства отдельного нейрона, генерацию спайков и состояние с постоянным уровнем потенциала. Модель относительно проста и обеспечивает качественное описание многих ситуаций, наблюдаемых экспериментально.

1.2.14 Модель Хубера-Брауна (Huber–Braun model)

Для численного моделирования процессов, происходящих в нейроне, была использована модель типа Ходжкина-Хаксли, предложенная Хубером и Брауном [6]. В отличие от классической модели, нейроны в модели Хубера-Брауна температурно-зависимые, что дает возможность получить все известные режимы, наблюдавшиеся в экспериментах.

Значения параметров выбирают из условия лучшего согласования с экспериментальными данными [5].

1.2.15 Модель Головача [11]

Система тринадцатого порядка, учитывающая наличие в полном токе, компонент, по-разному зависящих от концентрации ионов кальция. Является моделью нейрона стоматогастрического ганглия краба Cancer borealis.

1.2.16. Golomb,Guckenheimer,Gueronmodel

Система 7-го порядка, содержащие те же токи, что и модель Головача, но сгруппированными зависимыми переменными aj, bj, динамика которых качественно похожа. Эта модель качественно воспроизводит динамику потенциала мембраны, описываемую предыдущей моделью.

1.2.17. Модель Вилсона-Кована (Wilson-Cowan model) [12]

Одна из моделей средних полей, которые оперируют усредненными по нейронному ансамблю переменными. В модели имеются 2 переменные, одна из которых описывает число возбужденных, а другая – число тормозных нейронов в точке среды.

1.2.18. Модель спайкового отклика (SRM– SpikeResponseModel) [7]

Обобщение модели порогового интегратора (leaky integrate-and-fire model). В этой модели параметры зависят от времени последнего спайка. Состояние нейрона описывается одной переменной u.При отсутствии спайка u обновляет свое значение: urest= 0. Каждый приходящий спайк изменяет значение u (вносит возмущение), и проходит некоторое время, прежде чем u вновь становится равным 0. Функция описывает время, требующееся на ответ на приходящий спайк. Если после суммирования эффектов от нескольких приходящих спайков значение uдостигает порога, генерируется выходной спайк.

Порог не является фиксированным и также может зависеть от времени последнего спайка. Поэтому управляя порогом, можем моделировать явления абсолютной и относительной рефрактерности.

1.2.19. Выводы к параграфу 1.2

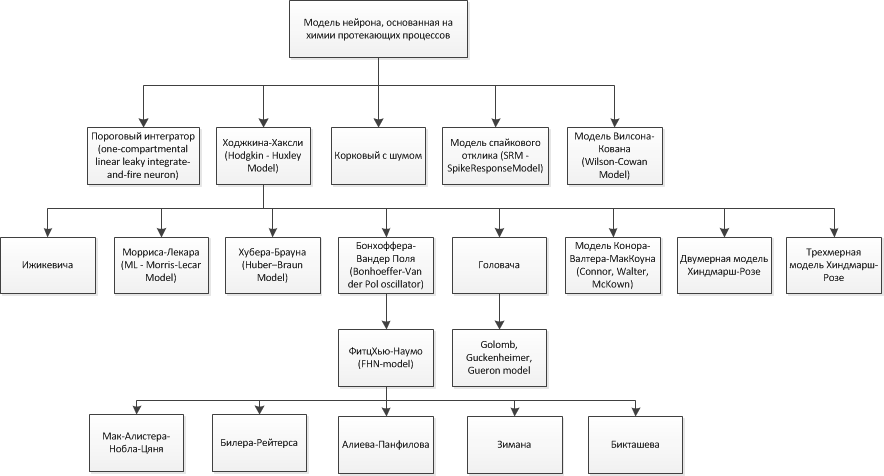

На основе вышесказанного можно построить следующую классификацию рассмотренных физиологических моделей нейронов (рис.11):

Рис.11. Классификация физиологических моделей нейронов

1.3 Феноменологические модели нейрона

1.3.1 Бионический нейрон В.Б. Вальцева [6]

Нейрон имеет входы и выходы. При этом входы делятся на несколько типов: возбуждение, регуляция, память, торможение и запрет. Текущее состояние нейрона определяется текущими значениями потенциала и порога. Нейрон способен принимать на входы импульсы и в возбужденном состоянии подавать импульсы на выход.

Текущее состояние нейрона меняется со временем. Если подача на входы импульсов отсутствует, то значение текущего потенциала стремится к нулю по экспоненциальному закону.

При этом значение текущего порога со временем стремится к некоторому постоянному значению, называемому порогом покоя. Порог покоя – величина.

Потенциал нейрона ограничен величинами Pmin и Pmax соответственно снизу и сверху (Pmin ≤ 0; Pmax> 0). Порог ограничен сверху величиной Tmax, снизу – величиной Tmin. Ограничения потенциала и порога учитываются при расчёте эффекта от поступившей импульсации.

Принимать сигналы (импульсы) нейрон может с помощью входов. Каждый вход нейрона характеризуется весовым коэффициентом W (вес входа). Импульсы, поступая на вход нейрона, изменяют его текущее состояние. Эффект от импульса определяется типом входа, на который он поступил, весом этого входа а также текущим состоянием нейрона.

Одиночный импульс, пришедший на вход нейрона типа возбуждение, повышает величину потенциала нейрона на некоторое значение H, которое представляет собой произведение веса синапса, по которому пришел импульс, и функции f(P)(0,1). f(P) стремится к нулю при P стремящемся к Рmax.

Таким образом: если нейрон не возбуждён (потенциал равен нулю), то импульс увеличивает значение потенциала на величину, равную весу входа. Продолжительная периодическая импульсация поднимает потенциал «ступеньками», высота которых убывает с возрастанием самого потенциала. Высота ступенек становится равной нулю, когда потенциал достигает предельного максимального значения (Рmax). При данном задании функции, потенциал может превышать максимальное значение на величину, пренебрежимо малую.

Если на вход возбуждения нейрона последовательно подавать импульсы так, что бы либо их частота или вес входа компенсировали коэффициент затухания потенциала, то потенциал будет ступенчато возрастать.

Сходным образом ведёт себя вход торможения. Однако его роль заключается в уменьшении потенциала на величину H, которая рассчитывается аналогично (меняются только знак аргумента функции fи в роли ограничителя выступает Рmin). Если на вход торможения нейрона последовательно подавать импульсы так, что бы либо их частота или вес входа компенсировали коэффициент затухания потенциала (с обратным знаком), то потенциал будет ступенчато убывать

Изменение значений порога осуществляется импульсацией на входы регуляции и запрета. Импульс, поступивший на вход регуляции, уменьшает значение порога на величину H, которая рассчитывается также как Hдля тормозящего входа. Соответственно запрет увеличивает значение порога на величину H и вычисляется аналогично величине Hвозбуждающего входа.

Особенным образом работает вход памяти. Аналогично возбуждению он увеличивает потенциал, но приращение потенциала теперь зависит не только от веса входа, но также от текущего состояния коэффициента обученности. Коэффициент обученности в отличие от веса меняет своё значение динамически в процессе работы нейронной сети. Он может принимать значения в диапазоне от 0 до 1.

Если µ = 0, то вход считается необученным – в этом случае импульсация на этот вход не оказывает никакого влияния на состояние нейрона. Максимально обученный вход (µ = 1) работает аналогично входу возбуждения с весом W, пока значение µ снова не изменится (уменьшится).

Обучение, переобучение, разобучение – механизмы, регулирующие значение µ и, как следствие, работу входов памяти нейрона.

Обучение входа – увеличение µ на некоторую постоянную величину ∆µ+ (очевидно меньшую единицы), так называемую, способность к обучению. Эта величина неизменна и зафиксирована в значении ∆µ+ = 0,2. Обучение происходит при одновременном выполнении условий:

1) на данный вход поступил сигнал

2) сигнал на вход памяти был подкреплён сигналом с входа возбуждения (сигнал на возбуждение должен прийти не позже чем через время ∆T)

3) значение порога в этот момент было меньше, чем порог покоя (что возможно только при наличии регулирующей импульсации).

Разобучение – уменьшение µ, происходит в тех случаях, когда сигнал, поступивший на вход памяти, не был подкреплён последующим сигналом на вход возбуждения, или не сопровождался регулирующей импульсацией (при этом T ≥T0). В этой ситуации значение µ уменьшится на ∆µ-.

Таким образом, вход памяти отличается от входа возбуждения умением менять значимость своего вклада в общий потенциал в зависимости от характера импульсации.

Помимо общей для всех типов входов весовой характеристики W и частных характеристик входов типа память (µ, ∆µ+, ∆µ-) каждый вход также характеризуется величиной Delay. Delay определяет задержку поступления импульсации с одного нейрона на другой.

В модели это реализуется следующим образом: каждый вход запоминает импульс, поступивший на него, но эффект от него рассчитывает лишь спустя время Delay.

Генерация импульсов происходит, если величина ∆Ω = P-Tположительна, т.е. потенциал превысил порог. Частота генерации импульсов зависит от ∆Ω линейно.

Ограничения на частоту импульсации вытекают из верхнего ограничения на потенциал и нижнего ограничения на порог (Pmax, Tmin).

Математическая модель составлялась на основе знаний о работе реального биологического нейрона, с некоторыми принятыми упрощениями.

2 Заключение

На сегодняшний день создано большое количество моделей отдельных нейронов и моделей ИНС. В данной работе была предпринята попытка обобщить накопленные знания, касающиеся отдельных искусственных нейронов, и, исходя из этой цели, для существующих моделей нейроновбылиприведены различные классификации: по положению нейронов в топологии сети, в зависимости от аппаратной реализации нейронов и по степени разработки математического описания модели нейрона и качественного описания его поведения. По последнему критерию нейроны разделены на формальные (для которых в свою очередь также приводится классификация по нескольким критериям), физиологические и феноменологические.

В результате обзора существующих моделей становится видно, что существует достаточное количество нейронов, описывающих естественный нейрон очень упрощенно. Они нашли свое применение в области распознавания образов, для решения задач классификации и т.д. Также существует множество моделей, которые при описании нейрона ставят своей целью количественное описание поведения нейрона. Однако до сих пор остается непонятным, приводит ли усложнение нейрона, попытки отображения им все новых свойств естественного нейрона, к существенному прогрессу и улучшению результатов решаемых нейронами задач.

Литература

- Клюкин В.И., Николаенков Ю.К. Электрические и математические модели нейронов. НС прямого распространения. Учебное пособие. – Издательский центр Воронежского государственного университета, 2008. – 63с.

- Елькин Ю.Е. Простейшие модели возбудимых сред. — Электрон. дан. —MathematicalCell - Режим доступа:http://www.mathcell.ru/ru/obzors/obzor_Elkin2.shtml,свободный. — Загл. с экрана.

- Чижов А.В. Математические модели ионных каналов, нейронов и нейронных популяций// От нейрона к сознанию. – СПб, 2009. – с.91-110.

- Чижов А.В, Турбин А.А. От моделей единичных нейронов к моделям популяций нейронов// Нейроинформатика. №1, 2006.- с.76-88.

- Осипов Г.В. Синхронизация при обработке и передаче информации в нейронных сетях. Учебно-методические материалы по программе повышения квалификации «Хранение и обработка информации в биологических системах» - Нижний Новгород, 2007. - 99 с.

- Елкин С.С., Елкин С.В., Клышинский Э.С. Бионический подход при создании комплекса моделей нейронов — Электрон. дан. —Публикации по бионическим нейронным сетям - Режим доступа:http://agpl.ru/bionic-neural-nets/publ-bionic-nets.html,свободный. — Загл. с экрана.

- Spike response model (SRM) — Электрон. дан. — NeuronModels- Режим доступа:http://icwww.epfl.ch/~gerstner/SPNM/node27.html,свободный. — Загл. с экрана.

- Основы искусственных нейронных сетей—Электрон. дан. — Нейронные сети - Режим доступа: http://neuronets.chat.ru/foundations.html, свободный. — Загл. с экрана.

- Тарков М.С. Нейрокомпьютерные системы - Интернет-университет информационных технологий - ИНТУИТ.ру, БИНОМ. Лаборатория знаний, 2006. -144с.

- Сараев П.В. Нейросетевые методы искусственного интеллекта. Учебное пособие. –Липецк,2007. – 64с.

- Г.Д.И. Абарбанель, М.И. Рабинович, А.Селверстон и др. Синхронизация в нейронных ансамблях // Успехи физических наук, №4, 1996. – с.363-389

- В.И. Некоркин. Нелинейные колебания и волны в нейродинамике // Успехи физических наук, №3, 2008. – с.313-324.